- 15 Ocak 2019

- 303

- 71

Selamlar, bugün web testlerine başlamadan önce bilgi toplama konusunu işleyeceğiz. Bilgi toplama çalışmaları yapmak için öncelikle mantığı oturtmalıyız, bunun için ufak bir liste yaptım bu liste baz alınarak kendimizi temel seviyede hedef hakkında bilgi toplayabilecek hale getirebiliriz.

IP ADRESİ İLE BİLGİ ALMA

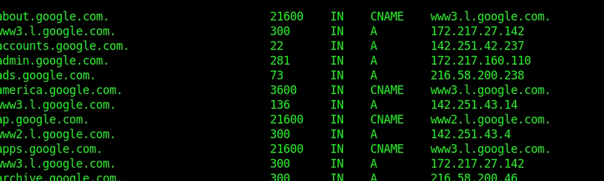

Hedef sistem hakkında bilgi toplamaya başlamak için önceliğiniz domain adresine bağlı olan ana ip adresini bulmak olsun. Eğer ki sistem cloudflare kullanıyorsa viewdns gibi sitelerden eski ip kayıtlarını toplayarak gerçek ip adresini bulmaya yönelik testler yapabilirsiniz. Veya sunucu içerisinde mx servisleri o ip adresinden geçiyor ise bir kayıt formu veya haber beslemesi kısmından testbirmail@dnshookicinkullanacağınsistem.com verip sizlere gelen mx ve dns A - AAA kayıtlarından bilgi toplamaya çalışabilirsiniz.

Bunlarla beraber metasploit içinde olan cloud_lookup aracılığı ile testler gerçekleştirebilir, dnsmap - dnsenum gibi yardımcı araçlar sayesinde daha fazla bilgiler elde edebilirsiniz.

SUB DOMAİN KEŞFİ

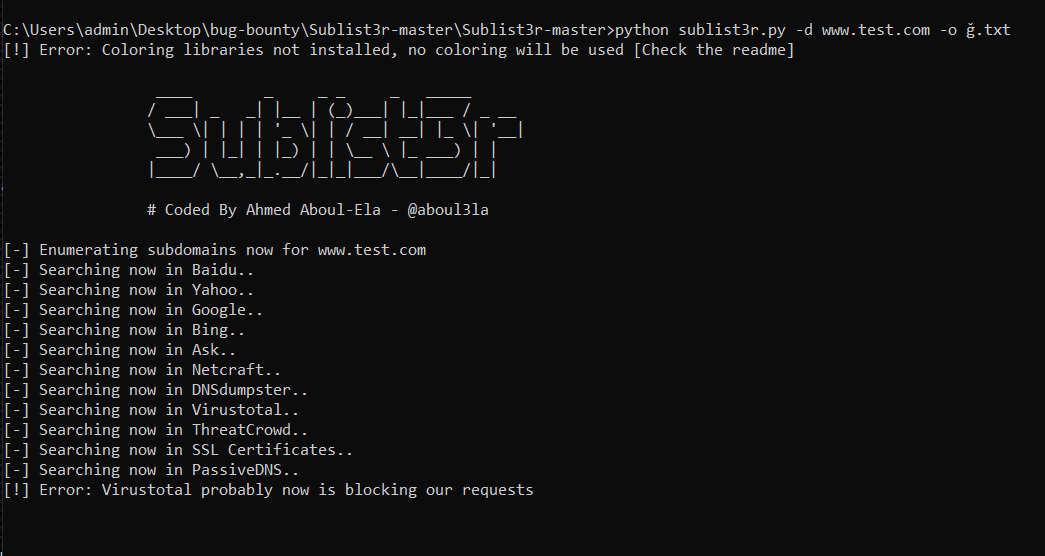

Bir web sitesinin altında birden fazla domain bulunabilir, bunlarla beraber bu sitenin backup dosyaları, yanlış yapılandırma ve güvenlik açıkları çıkabilir, hatta domain süresi geçtiyse sub domain takeover yapılabilir. Ben sublist3r adlı aracı kullanacağım.

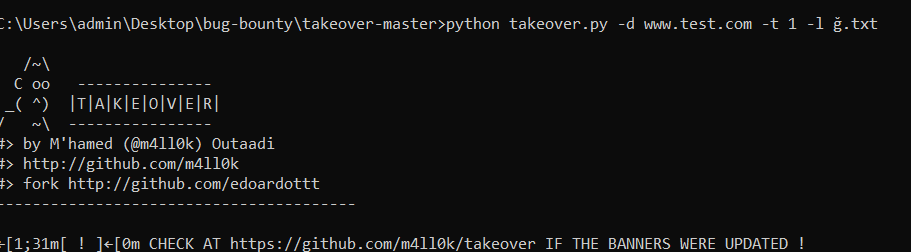

SUB DOMAİN TAKEOVER CHECK

Çıkan çıktıları ise -o parametresi vererek Ğ adlı txt dosyama yazdırıyorum, testlerde çokça karşınıza çıkacak olan bir konudur, web sitelerini kaydedip yapacağım bir sonraki işleme göz atabilirsiniz. Yapılacak olan işlem ise taradığımız ve bulunan hedef sub domainlerin süresi bitti mi hakkında yapılan ufak bir test.

Bu duruma örnek olarak Trump'ın kişisel web sitesinin domain takeover yolu ile alınıp index atılmasına sebebiyet verdi.

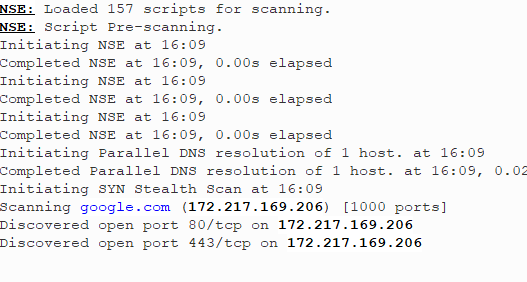

NMAP TARAMASI

Bu testlerin ardından ilgili sitenin ip adresini nmap aracılığı ile tarayabilir, sistemin kullandığı servisler hakkında bilgi edinebilirsiniz. Örnek bir nmap parametresi ; -sV (servis versiyonu) -sT (full tcp) -sU (udp) -sS (syn) gibi tarama yöntemleri verebilirsiniz. Çalıştıracağım komut nmap test.com -sV -Pn -sT -p-

Bunlarla beraber çalışan portları test etmek için -pBULDUĞUNPORT --script=buldugunport şeklinde vulnarable / check / enum gibi taralamalar yapabilirsiniz.

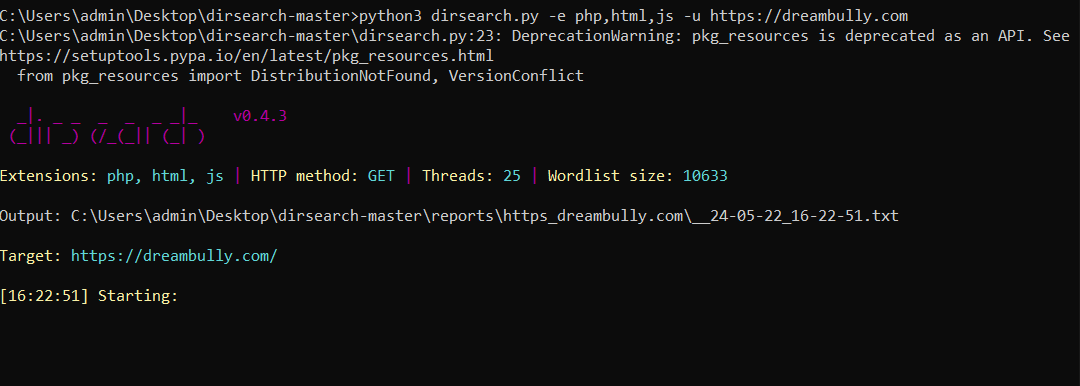

DİZİN TARAMASI

Hedef site üzerinde dizinleri taramak oldukça önemli, yazıldığı dili, admin yollarını, backup dosyalarını, input verebileceğin parametreleri belki çalışan farklı servisleri öğrenip test edebileceğiniz için güzel bir wordlist kullanarak testlerinizi gerçekleştirebilirsiniz. Bunun için dirb aracı ile yada wfuzz gibi araçlarla isteğinize göre taramalar gerçekleştirebilirsiniz. Aşağıda görmüş olduğunuz gibi -e parametresi vererek php - js - html içeriklerini istediğimizi ve kalanını göz ardı etmesi gerektiğini belirttik.

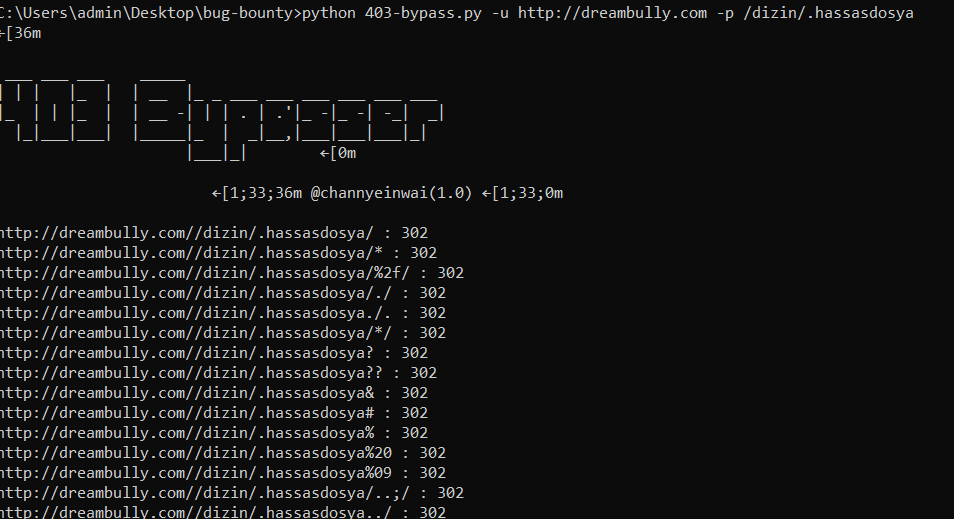

403-BYPASS TEKNİK

Bulduğunuz bu dizinler ve dosyalar arasından 403 - 405 gibi server tarafından mesajlar üretilebilir, bazıları bunlara savunmasız olmaktadır örneğin /.htaccess in yanıtı 403 olarak geldi, bypass edebilmek için ./#/.htaccess /?/.htaccess/-s gibi yöntemlerle veya http headerlar ile X-Original gibi değerlere path verilebilirse bypass gerçekleşebilir. Bu durumu otomatize olarak yapmak için 403-bypasser adlı aracı kullanacağım.

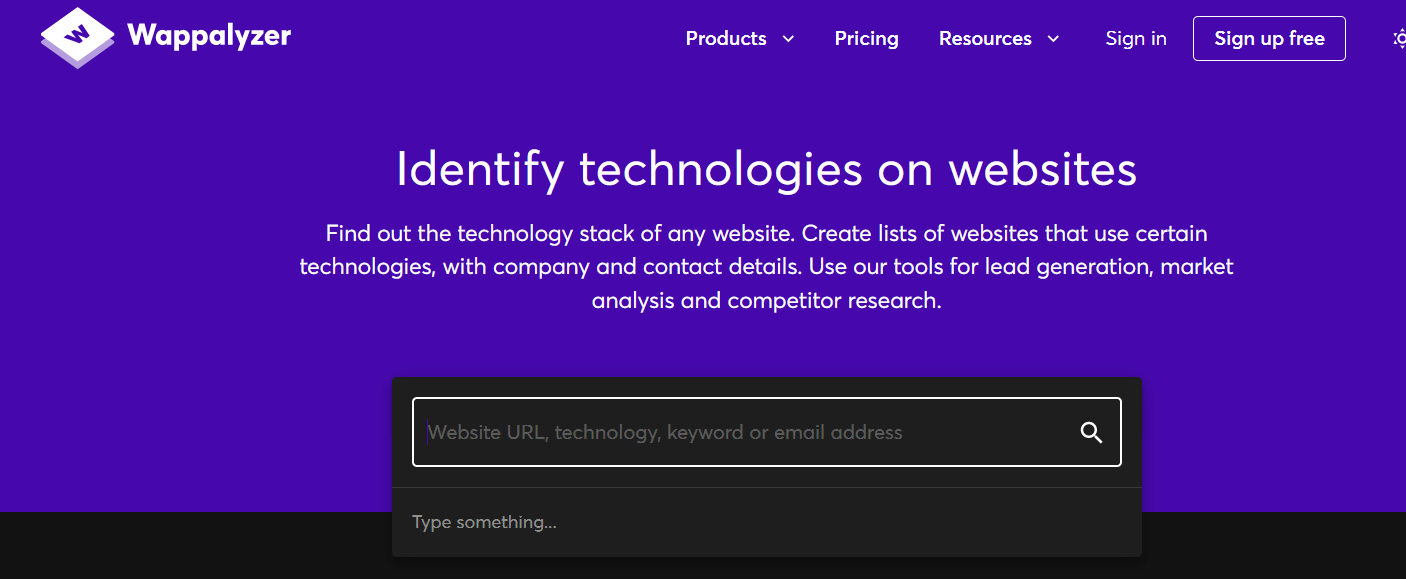

WAPPALİZER İLE BİLGİ TOPLAMA

Weballizer adlı eklenti ile sitenin mimarisini öğrenebilir ve varsayılan pluginleri görebilirsiniz. Bunlarla beraber sistemin kullandığı apache - litespeed gibi durumları görebilir bunlara yönelik testlerinizi sürdürebilirsiniz. Her açılan sayfada aktif olmaktadır, eklenti ile kullanmanızı öneririm.

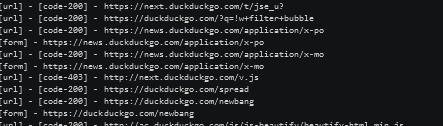

GOSPİDER İLE BİLGİ TOPLAMA

Şimdi ise hedef site hakkında toplyabildiği kadar birçok url ve path leri çıkarabileceğimiz otomatik olarak istenilen parametreler ile çalışabilen gospider adlı aracı kullanalım. Default taramalar için gospider -s "DreamBully.com is for sale | HugeDomains" -o cikti -c 10 -d 1 şeklinde taramalar yapılabilir.

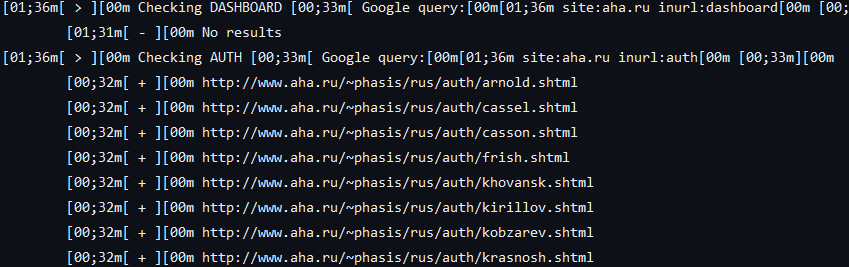

FAST DORK GOOGLE SCAN

Google üzerinde dorklama çalışmaları önemlidir, bunun için manuel testler yapmak yerinde Fast Google Dork Scan gibi programları kullanabilir bu verileri de output'larımıza ekleyebiliriz. Hedef sitenin dosya uzantılarını, admin pathlerini, cdn, backuplarını, input verilebilecek alanları bizim için tarar.

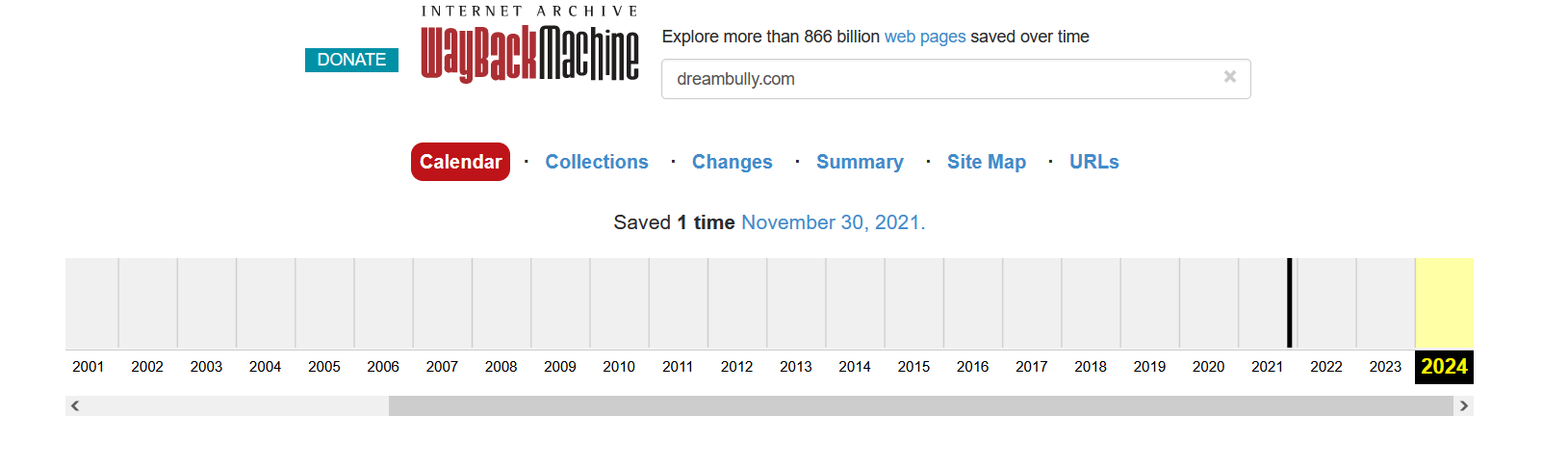

WAYBACK MACHİNE

Web sitelerinin tutulduğu eski kayıtlar sayesinde önemli bilgiler edinebilir, Sayfaların eski kaynak kodları okunabilir, bulunmayan dizin ve dosyalar bu tür yöntemlerle bulunabilir, admin veya farklı user ve e mail hesapları ortaya çıkabilir bunlarla beraber önemli dosyaları okuyabilir, hatta indirebildirsiniz.

Bu web hakkında temal veya basit seviyede bilgi almanın ilk konusuydu, herşeyi tek konuya sığdırmak istemedim zaman buldukça part part diğer içerikleri paylaşırım beni okuduğunuz için teşekkür ederim sağlıcakla kalın...

okuduğunuz için teşekkür ederim sağlıcakla kalın...

IP ADRESİ İLE BİLGİ ALMA

Hedef sistem hakkında bilgi toplamaya başlamak için önceliğiniz domain adresine bağlı olan ana ip adresini bulmak olsun. Eğer ki sistem cloudflare kullanıyorsa viewdns gibi sitelerden eski ip kayıtlarını toplayarak gerçek ip adresini bulmaya yönelik testler yapabilirsiniz. Veya sunucu içerisinde mx servisleri o ip adresinden geçiyor ise bir kayıt formu veya haber beslemesi kısmından testbirmail@dnshookicinkullanacağınsistem.com verip sizlere gelen mx ve dns A - AAA kayıtlarından bilgi toplamaya çalışabilirsiniz.

Bunlarla beraber metasploit içinde olan cloud_lookup aracılığı ile testler gerçekleştirebilir, dnsmap - dnsenum gibi yardımcı araçlar sayesinde daha fazla bilgiler elde edebilirsiniz.

SUB DOMAİN KEŞFİ

Bir web sitesinin altında birden fazla domain bulunabilir, bunlarla beraber bu sitenin backup dosyaları, yanlış yapılandırma ve güvenlik açıkları çıkabilir, hatta domain süresi geçtiyse sub domain takeover yapılabilir. Ben sublist3r adlı aracı kullanacağım.

SUB DOMAİN TAKEOVER CHECK

Çıkan çıktıları ise -o parametresi vererek Ğ adlı txt dosyama yazdırıyorum, testlerde çokça karşınıza çıkacak olan bir konudur, web sitelerini kaydedip yapacağım bir sonraki işleme göz atabilirsiniz. Yapılacak olan işlem ise taradığımız ve bulunan hedef sub domainlerin süresi bitti mi hakkında yapılan ufak bir test.

Bu duruma örnek olarak Trump'ın kişisel web sitesinin domain takeover yolu ile alınıp index atılmasına sebebiyet verdi.

NMAP TARAMASI

Bu testlerin ardından ilgili sitenin ip adresini nmap aracılığı ile tarayabilir, sistemin kullandığı servisler hakkında bilgi edinebilirsiniz. Örnek bir nmap parametresi ; -sV (servis versiyonu) -sT (full tcp) -sU (udp) -sS (syn) gibi tarama yöntemleri verebilirsiniz. Çalıştıracağım komut nmap test.com -sV -Pn -sT -p-

Bunlarla beraber çalışan portları test etmek için -pBULDUĞUNPORT --script=buldugunport şeklinde vulnarable / check / enum gibi taralamalar yapabilirsiniz.

DİZİN TARAMASI

Hedef site üzerinde dizinleri taramak oldukça önemli, yazıldığı dili, admin yollarını, backup dosyalarını, input verebileceğin parametreleri belki çalışan farklı servisleri öğrenip test edebileceğiniz için güzel bir wordlist kullanarak testlerinizi gerçekleştirebilirsiniz. Bunun için dirb aracı ile yada wfuzz gibi araçlarla isteğinize göre taramalar gerçekleştirebilirsiniz. Aşağıda görmüş olduğunuz gibi -e parametresi vererek php - js - html içeriklerini istediğimizi ve kalanını göz ardı etmesi gerektiğini belirttik.

403-BYPASS TEKNİK

Bulduğunuz bu dizinler ve dosyalar arasından 403 - 405 gibi server tarafından mesajlar üretilebilir, bazıları bunlara savunmasız olmaktadır örneğin /.htaccess in yanıtı 403 olarak geldi, bypass edebilmek için ./#/.htaccess /?/.htaccess/-s gibi yöntemlerle veya http headerlar ile X-Original gibi değerlere path verilebilirse bypass gerçekleşebilir. Bu durumu otomatize olarak yapmak için 403-bypasser adlı aracı kullanacağım.

WAPPALİZER İLE BİLGİ TOPLAMA

Weballizer adlı eklenti ile sitenin mimarisini öğrenebilir ve varsayılan pluginleri görebilirsiniz. Bunlarla beraber sistemin kullandığı apache - litespeed gibi durumları görebilir bunlara yönelik testlerinizi sürdürebilirsiniz. Her açılan sayfada aktif olmaktadır, eklenti ile kullanmanızı öneririm.

GOSPİDER İLE BİLGİ TOPLAMA

Şimdi ise hedef site hakkında toplyabildiği kadar birçok url ve path leri çıkarabileceğimiz otomatik olarak istenilen parametreler ile çalışabilen gospider adlı aracı kullanalım. Default taramalar için gospider -s "DreamBully.com is for sale | HugeDomains" -o cikti -c 10 -d 1 şeklinde taramalar yapılabilir.

FAST DORK GOOGLE SCAN

Google üzerinde dorklama çalışmaları önemlidir, bunun için manuel testler yapmak yerinde Fast Google Dork Scan gibi programları kullanabilir bu verileri de output'larımıza ekleyebiliriz. Hedef sitenin dosya uzantılarını, admin pathlerini, cdn, backuplarını, input verilebilecek alanları bizim için tarar.

WAYBACK MACHİNE

Web sitelerinin tutulduğu eski kayıtlar sayesinde önemli bilgiler edinebilir, Sayfaların eski kaynak kodları okunabilir, bulunmayan dizin ve dosyalar bu tür yöntemlerle bulunabilir, admin veya farklı user ve e mail hesapları ortaya çıkabilir bunlarla beraber önemli dosyaları okuyabilir, hatta indirebildirsiniz.

Bu web hakkında temal veya basit seviyede bilgi almanın ilk konusuydu, herşeyi tek konuya sığdırmak istemedim zaman buldukça part part diğer içerikleri paylaşırım beni